Одной из самых зловещих функций искусственного интеллекта является его способность воспроизводить любой голос даже на основе короткой записи. Подобные фальшивые видеозаписи могут фальсифицировать выступления политиков или знаменитостей, приводя к катастрофе. Кроме того, дипфейки активно используются мошенниками, чтобы подделывать голоса родственников для вымогательства денег.

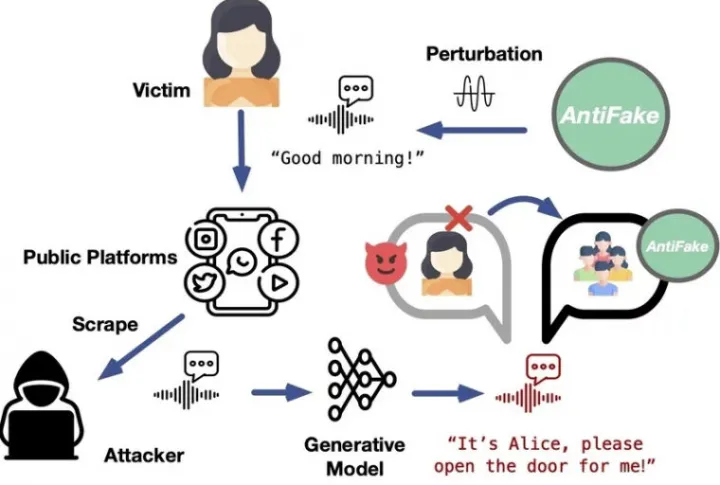

Эта ситуация побудила инженеров с кафедры компьютерных наук Вашингтонского университета в Сент-Луисе создать антифейк, который поможет бороться с фальшивыми голосами. Новый программный инструмент, который так и называется — AntiFake, является первой системой, которая в принципе предотвращает создание дипфейков.

Традиционные инструменты для борьбы с дипфейками работают за счёт того, что обнаруживают подделки на основе тончайших изменений исходного видео. Однако AntiFake работает иначе: программа использует технику состязательного искусственного интеллекта, которой изначально пользовались киберпреступники. Однако теперь инженеры использовали эту технику против самих злоумышленников, искажая записанный аудиосигнал ровно настолько, чтобы он звучал нормально для человека, но искажённо для ИИ.

Иными словами, если злоумышленник создал дипфейк на основе изменённой антифейком записи, голос будет изменённым. Разработчики уже провели испытания своей программы и доказали, что технология эффективна на 95% в предотвращении синтеза дипфейков. Поэтому авторы AntiFake убеждены, что стратегия использования методов противников против них самих будет чрезвычайно эффективной в будущем.