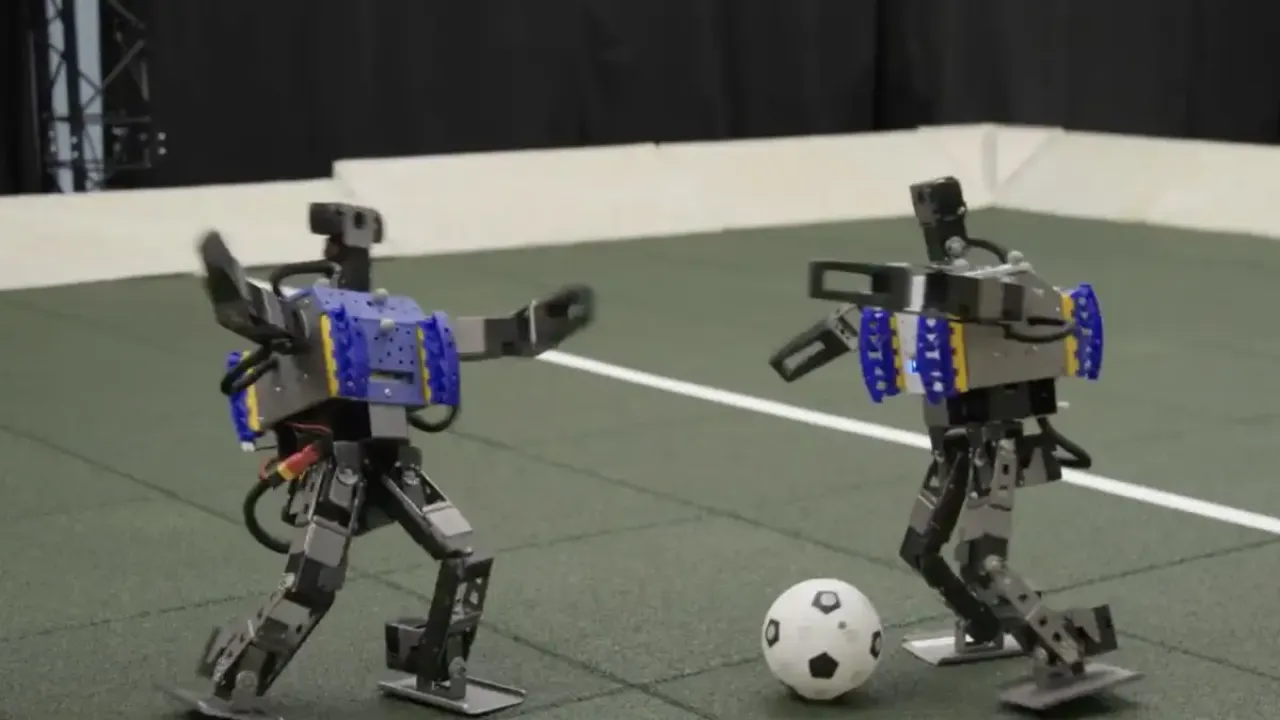

Гай Левер из Google DeepMind и его коллеги научили двуногих роботов не только ходить и бить по мячу, но и по-настоящему играть в футбол, ловко вставая после падения и обыгрывая соперника. Левер добился таких потрясающих результатов, на протяжении 240 часов обучая искусственный интеллект при помощи подкрепления, — это означает, что андроиды действуют не по сценарию, а задействуя своё гибкое мышление.

Небольшие роботы в высоту достигают всего 50 сантиметров, однако в их небольших телах скрыто 20 гибких суставов, благодаря чему они ловко обращаются с мячом. Однако ключевым компонентом является именно искусственный интеллект андроидов, который обучался при помощи метода проб и ошибок, а глубокие слои нейронных сетей позволили роботам имитировать действия человека.

По сравнению с ботами, работающими с заранее заданными алгоритмами, механические футболисты смогли передвигаться на 181 процент быстрее, поворачиваться на 302 процента стремительнее и бить по мячу на 34 процента сильнее. Такое поведение очень сложно спроектировать вручную, поэтому эффективнее оказалась методика, предложенная командой Google DeepMind: физический движок моделирует различные ситуации и постоянно учится на их основе, а не применяет один и тот же алгоритм раз за разом.

Впрочем, как шутят создатели ловких ботов, их задача заключается не в том, чтобы создать роботов, играющих в Премьер-лиге, а в том, чтобы понять, как использовать методы синтетического обучения для формирования различных навыков андроидов. Благодаря этому роботы смогут работать на реальных производствах, усложняя своё поведение с каждым рабочим днём.